AI in cybersecurity; Vriend of Vijand?

AI heeft de werkplek op zijn kop gezet. Op dit moment loopt cybersecuritypersoneel achter op hun kwaadwillende tegenhangers, er is sprake van een ongelijk speelveld. Ervaring met prompt engineering is nodig om AI effectief te kunnen inzetten – en zou een transformatieve benadering van penetratietesten kunnen betekenen, met nieuwe mogelijkheden voor kwetsbaarheidsbeoordeling en dreigingssimulatie.

Naarmate het cyberbeveiligingslandschap zich verder ontwikkelt, kan de integratie van AI-gestuurde technieken in pentesting-praktijken de algehele beveiligingspositie van organisaties verbeteren. Door deze innovaties te omarmen, kunnen beveiligingsprofessionals opkomende bedreigingen voorblijven en hun systemen en gegevens beter beschermen.

Bij Cyber Security Challengers zijn we van plan om precies dat te doen. Wat denk jij? Doe mee aan de discussie, of sluit een keer aan onze tafel aan! Lees hieronder verder.

De afgelopen jaren heeft Artificial Intelligence (AI) (of eigenlijk Large Language Models (LLM’s) een enorme vlucht genomen en wordt het op tal van gebieden toegepast. Voor het leesgemak zullen we de term AI hanteren, maar eigenlijk is er een verschil waar we in een later artikel op terug zullen komen.

Nu AI steeds vaker op de werkvloer gebruikt wordt, hebben informatiebeveiligingsexperts verschillende uitdagingen. Voor het doel van deze discussie en onderwerp hanteren we de volgende twee categorieën.

• Extern: Externe actoren gebruiken AI om hun aanvalsoppervlak, methoden, snelheid en omvang te vergroten. Deze methoden zijn vrij nieuw, maar worden steeds gevaarlijker naarmate de aanvaller beter wordt in het gebruik van AI en AI-modellen beter worden in wat ze doen.

• Intern: Met alle nieuwe mogelijkheden van AI zijn verschillende bedrijven begonnen met het integreren van AI in hun diensten. Denk aan Microsofts Copilot, welke is geïntegreerd in de Microsoft Suite. Denk aan Google’s Gemini, Cisco’s AI-diensten of Meta’s AI (-een vrij ongeinspireerde naam als je het mij vraagt). Deze AI-diensten zijn mogelijk geïntegreerd in uw bedrijf, waar ze al dan niet toegang hebben tot interne bestanden, e-mails, chats en netwerkinformatie. Belangrijk dan ook om zowel de cybersecurity als de privacy risico’s van AI goed te beheersen. Kaders als de AVG, NIS2, de AI Act, ISO42001 & NIST RMF en medewerkers met ervaring zijn hiervoor nodig.

Hoe prompt engineering een cybersecurity professional kan helpen

Prompt engineering verwijst naar het proces van het ontwerpen en verfijnen van invoerprompts om gewenste reacties uit AI-modellen te krijgen.

Simpel gezegd: door gebruik te maken van effectieve prompt engineering kan men een AI-tool input van hogere kwaliteit bieden en output van hogere kwaliteit ontvangen.

Waarom is dit relevant? – Door specifieke prompts te creëren, kunnen beveiligingsprofessionals AI-mogelijkheden benutten om verschillende aanvalsscenario’s te simuleren, kwetsbaarheden te beoordelen en inzichten te genereren die traditionele pentesting-methoden mogelijk over het hoofd zien.

Zoals wel vaker het geval is, is prompt engineering ook in te zetten als aanvaller. In een later artikel hebben we het over Prompt Injection, AI Jailbreaking en de ethische dilemma’s die AI oproept omdat een gebruiker niet kan zien welke acties er uitgevoerd worden op basis van zijn (mogelijk) onschuldige prompt.

Welke veranderingen brengt AI met zich mee?

AI brengt heel wat risico’s met zich mee, maar we gaan ons concentreren op de risico’s op het gebied van cybersecurity. Andere werk gerelateerde risico’s, zoals onjuist gebruik, overmatige afhankelijkheid, gebrek aan toezicht en de mogelijkheid om op grote schaal fouten te maken, bewaren we voor een andere keer.

Voor het gemak, en omdat we het eerder ook zo gedaan hebben, maken we onderscheid tussen externe gebruikers en interne gebruikers.

Extern:

Externe actoren gebruiken AI om hun aanvalsoppervlak, de snelheid van aanvallen en de omvang van aanvallen te vergroten. Simpel gezegd kunnen ze doen wat ze al deden, maar dan op veel grotere schaal. Door automatisering met behulp van AI kunnen ze ook aanvallen uitvoeren op gebieden waar ze dat voorheen niet deden omdat het voor hen niet rendabel was. Dit kan ertoe leiden dat bedrijven veel meer spam en phishing ontvangen. Kwetsbaarheden kunnen veel sneller en op grotere schaal worden uitgebuit, waardoor zero-days nog enger worden dan ze al waren.

Een interessant aanvalsoppervlak dat voorheen klein was, is de openbaar beschikbare informatie van een bedrijf of persoon. Externe actoren kunnen gebruikmaken van prompt engineering, prompt injection of AI jailbreaking om informatie op te halen die de AI ‘kent’ (heeft gebruikt bij het leren) over een bedrijf of persoon die niet openbaar beschikbaar zou moeten zijn. Zou moeten, en de realiteit, komen echter niet altijd overeen en er komt toch informatie in de dataset die gebruikt is voor het trainen van de AI terecht, of ergens op het internet (of deep web) te vinden is. Probeer je naam of die van je familie eens in Perplexity op te zoeken.

Intern:

Interne actoren kunnen AI gebruiken om controles op basis van autorisatie te omzeilen. Als documenten, e-mails, netwerkinformatie en alle andere gegevens waartoe een AI toegang heeft niet correct zijn geclassificeerd, kan een interne actor AI gebruiken door effectieve prompt engineering in te zetten om dergelijke gegevens op te halen. Hier worden “klassieke” controls op basis van identity & accessmanagement omzeild. Copilot is ingesteld om bestaande controls en usergroups te respecteren, maar wat als bestaande controls en usergroups niet goed staan ingesteld? Wat als men een effectieve prompt vindt om daarom heen te komen met AI-Jailbreaking?

Wat kan jij doen als cybersecurity professional?

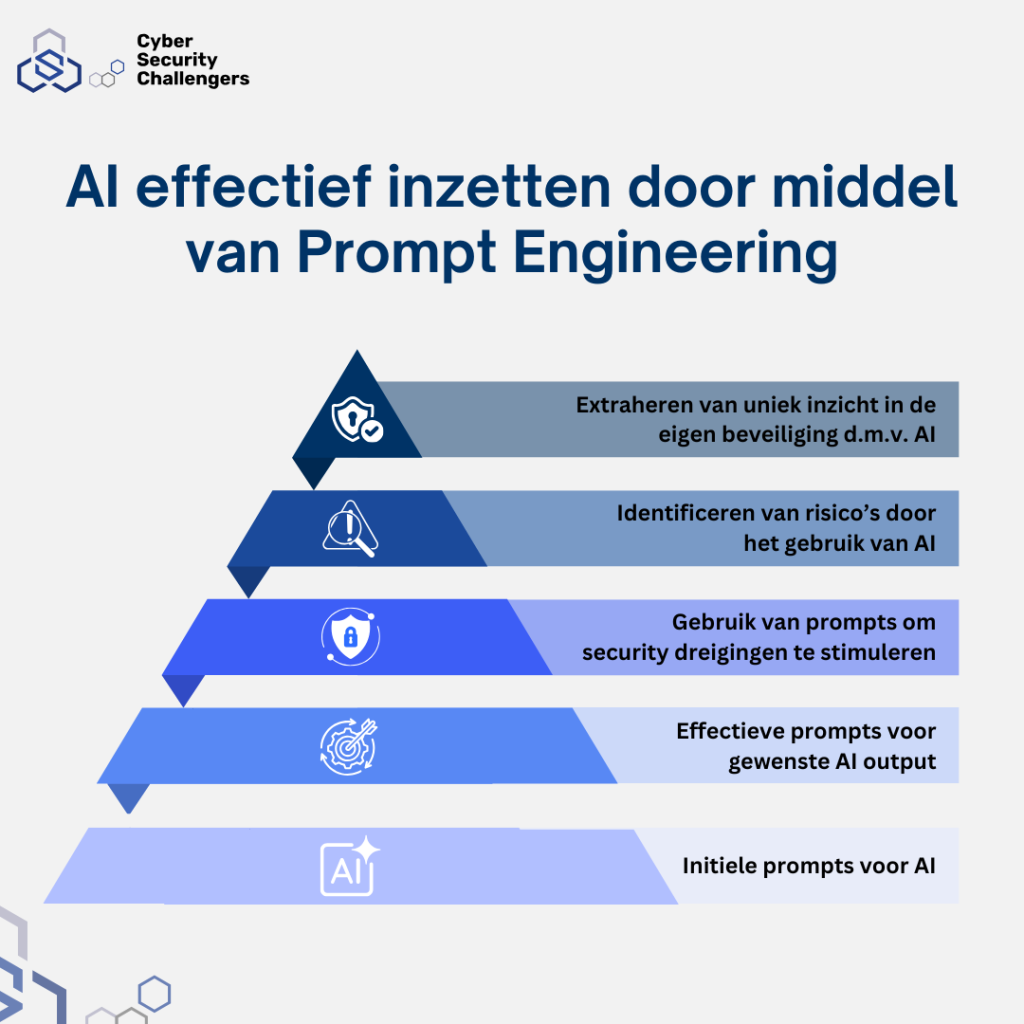

Zoals eerder te zien in onze piramide, is de eerste stap het maken van effectieve prompts voor AI interpretatie. Dat is ook voor cybersecuritypersoneel een goed begin. Wanneer men effectief prompts kan inzetten door kennis van prompt engineering kun je effectiever omgaan met AI.

Waarom?

• Extern: AI-tools kunnen worden gebruikt door pentesters met kennis van prompt engineering, of door prompt engineers met kennis van cyberbeveiliging om het externe aanvalsoppervlak te testen, het deep web te controleren, informatie in AI-tools zelf te controleren en een rapport voor de pentester of prompt engineer te genereren. Deze resultaten kunnen worden gebruikt om kwetsbaarheden beter te identificeren en oplossingen voor te stellen.

• Intern: Intern gebruik van AI kan worden ingezet om kwetsbaarheden in het gebruik van AI binnen een bedrijf te identificeren. Door gebruik te maken van effectieve prompt engineering kunnen pentesters met kennis van prompt engineering of prompt engineers met kennis van cyberbeveiliging kwetsbaarheden identificeren die zijn ontstaan door de tool die ze gebruiken om ze te identificeren.

Uitdagingen en overwegingen

Hoewel AI spannende mogelijkheden biedt voor cyberbeveiliging, is het niet zonder uitdagingen. Beveiligingsprofessionals moeten voorzichtig zijn met de ethische implicaties van het gebruik van door AI gegenereerde content en ervoor zorgen dat deze op verantwoorde wijze en binnen de wettelijke grenzen wordt toegepast. Bovendien is de effectiviteit van prompt engineering sterk afhankelijk van de kwaliteit van de onderliggende AI-modellen en de expertise van het cyberbeveiligingspersoneel bij het opstellen van effectieve prompts.

Daarnaast is oefenen met AI en de mogelijkheden in verband met cybersecurity niet altijd even makkelijk, omdat AI implementatie met argwaan wordt bekeken, en in sommige opzichten natuurlijk terecht.