Uitdagingen en strategieën voor risicomanagement op het gebied van AI

Kunstmatige intelligentie (AI) evolueert nog steeds in ijltempo en biedt enorme nieuwe kansen voor innovatie en efficiëntie. Dit brengt echter ook aanzienlijke risico’s en uitdagingen met zich mee, zoals op het gebied van beveiliging, data privacy, selectie bias (bevooroordeling) en regelgeving.

Omdat AI tools steeds meer geïntegreerd raken in de bedrijfsvoering (Machine Learning in ICT tools, LLM, generatieve AI), hebben organisaties een solide strategie voor risicomanagement en gegevensbeveiliging op het gebied van AI nodig om effectief en veilig deze ontwikkelingen te kunnen blijven volgen.

| AI biedt kansen maar ook uitdagingen. Cyber Security Challengers kan jouw organisatie daarbij helpen. |

Toenemend belang van AI risicomanagement

De adoptie van AI is de afgelopen jaren in alle sectoren sterk toegenomen. Volgens McKinsey had 78 % van de organisaties in 2024 AI geïmplementeerd, tegenover slechts 55 % het jaar ervoor.

Zonder duidelijk beleid en gestructureerd implementatieplan lopen bedrijven het risico zich bloot te stellen aan onbedoelde gevolgen. Het opzetten van governance, het monitoren van de ontwikkeling van AI modellen en het waarborgen van het juiste gebruik van gevoelige gegevens zijn allemaal belangrijk om ervoor te zorgen dat AI veilig en verantwoord wordt gebruikt.

Door deze risico’s proactief te beheren, kunnen organisaties het volledige potentieel van AI benutten en zich tegelijkertijd beschermen tegen schade.

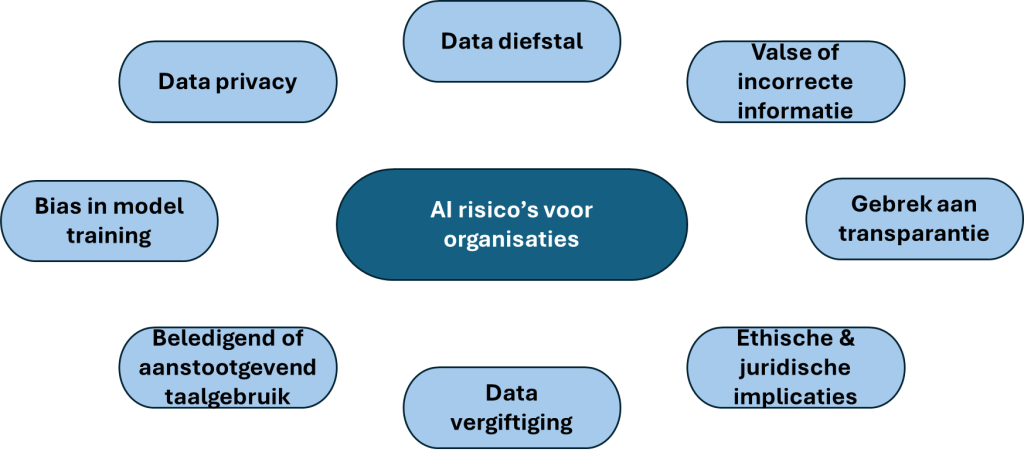

Belangrijkste risico’s van AI voor organisaties

AI kan efficiëntie en inzicht bevorderen, maar brengt ook een reeks potentiële risico’s voor organisaties met zich mee. Deze bedreigingen kunnen de bedrijfsvoering in gevaar brengen, reputaties schaden en organisaties blootstellen aan juridische of financiële gevolgen. Begrijpen waar AI mis kan gaan, is de eerste stap naar het bouwen van veilige, eerlijke en compliant systemen.

Hieronder een aantal veel voorkomende uitdagingen, met adviezen voor een risicomanagement framework om hiermee om te gaan.

1. Data privacy. AI systemen hebben enorme hoeveelheden data nodig om te functioneren. Zonder stringente controles kan dit leiden tot onbedoeld vrijgeven, misbruiken of lekken van gevoelige informatie, met als mogelijke gevolgen overtreding van complianceregels, verlies van vertrouwen bij klanten of boetes. Enkele voorbeelden:

- AI modellen kunnen onbedoeld auteursrechtelijk beschermd of eigendomsgebonden materiaal reproduceren (wat leidt tot problemen zoals data piraterij).

- Het onbedoeld doorgeven van persoonlijk identificeerbare Informatie aan online AI modellen kan leiden tot ongeautoriseerde toegang of datalekken, met name omdat deze modellen op externe servers staan.

- Gebruiksvoorwaarden van het model kunnen toestaan dat ingevoerde data worden opgeslagen of geanalyseerd om prestaties te verbeteren (met impact qua eigendom en toestemming).

2. Data diefstal. Naast de hierboven genoemde risico’s met betrekking tot data privacy, kunnen kwaadwillenden AI ook misbruiken om cyberaanvallen uit te voeren. Dit betreft onder andere zaken als prompt injection, model inversie en API misbruik.

AI tools kunnen ook gemanipuleerd worden om stemmen te klonen, valse identiteiten te genereren of overtuigende phishing mails te creëren, met de bedoeling om te frauderen, te hacken, iemands identiteit te stelen of diens privacy en veiligheid in gevaar te brengen. Veel van de momenteel in gebruik zijnde generatieve AI modellen zijn hierop nog onvoldoende beveiligd.

3. Valse of incorrecte informatie. Generatieve AI kan inhoud produceren die overtuigend en goed geformuleerd lijkt, maar feitelijk onjuist is. Stel dat een model ten onrechte rapporteert dat een groot technologiebedrijf zware financiële of andere problemen te wachten staat. Dit kan leiden tot marktvolatiliteit of erger, gebaseerd op onjuiste informatie.

4. Gebrek aan transparantie. Veel AI modellen werken op complexe manieren die moeilijk uit te leggen zijn. Wanneer bedrijven geen verantwoording kunnen afleggen over hoe beslissingen worden genomen, wordt het moeilijker om vertrouwen op te bouwen, fouten te identificeren of te voldoen aan wettelijke vereisten.

5. Ethische en juridische implicaties. Generatieve AI kan deepfakes produceren — hyperrealistische maar volledig verzonnen inhoud. In verkeerde handen kan dit leiden tot fake nieuws, vervalste stemmen of manipulatie van publieke opinie. Het vertrouwen in personen en instituties kan hierdoor ernstig worden geschaad. Overheden ontwikkelen AI specifieke regelgeving om het gebruik van AI technologie te reguleren. Bedrijven die zich niet houden aan de nieuwe regels rond verantwoording, toestemming, gegevensbescherming of anti-discriminatie, riskeren problemen zoals reputatieschade, aanklachten, boetes of juridische maatregelen.

6. Data vergiftiging. Datasets kunnen opzettelijk worden gemanipuleerd door kwaadwillende actoren tijdens het verzamelen of voorbereiden van de AI model training, waarbij corrupte of vijandige gegevens worden geïntroduceerd om het model tijdens de training te misleiden. Als geregistreerde gebruikersvragen worden opgenomen in trainingsdata, kunnen aanvallers in geval van een vijandige aanval schadelijke of misleidende inhoud introduceren om de toekomstige uitvoer van het model te manipuleren.

7. Beledigend of aanstootgevend taalgebruik. Ondanks geavanceerde algoritmen en zaken als Reinforcement Learning from Human Feedback (RLHF) training zijn AI systemen soms gevoelig voor het genereren van inhoud die als beledigend, schadelijk of misplaatst kan worden gezien. Historische incidenten, zoals het schandaal rond Microsoft’s Tay-chatbot die ongepaste inhoud begon te posten, bewijzen deze kwetsbaarheid. Zonder voldoende controle en toezicht kunnen deze AI tools onbedoeld negatieve en schadelijke aspecten van hun trainingsdata weerspiegelen of versterken.

8. Bias in model training. AI modellen kunnen selectie bias in de data, waarmee ze zijn getraind, weerspiegelen of versterken. Dit kan leiden tot oneerlijke beslissingen op het gebied van personeelswerving, kredietverlening of klantenservice. Dit stelt bedrijven bloot aan reputatieschade, juridische stappen of ingrijpen door toezichthouders als de uitkomsten bijvoorbeeld discriminerend blijken te zijn.

Een interessant en up-to-date overzicht van veiligheidsrisico’s voor LLM (Large Language Model) toepassingen zoals generatieve AI, is de OWASP (Open Worldwide Application Security Project) Top 10 for LLM applications (https://genai.owasp.org/llm-top-10/).

Ontwikkelen van een effectief en toekomstbestending AI risicomanagement framework

Het beheersen van AI risico’s vereist een gestructureerde, organisatiebrede aanpak die governance, verantwoording en continu toezicht in alle afdelingen integreert. Een sterk raamwerk zorgt ervoor dat AI systemen verantwoord worden ontwikkeld en geïmplementeerd en dat data wordt verwerkt in overeenstemming met alle relevante regelgeving.

Naarmate AI zich verder ontwikkelt, nemen ook de risico’s toe. In de komende jaren zullen toenemende regelgevende controle en stijgende publieke verwachtingen ten aanzien van privacy hogere eisen stellen aan risicomanagement programma’s. Tegelijkertijd zal een groeiend aanvalsoppervlak, gedreven door het wijdverbreide gebruik van generatieve AI en voorspellende modellen, de druk op cybersecurity verhogen.

Organisaties die voorop willen blijven lopen, moeten AI niet alleen als een hulpmiddel beschouwen, maar ook als een kritische operationele toepassing die constant toezicht vereist. Bedrijven zullen transparantie, eerlijkheid en documentatie moeten garanderen in elke fase van de AI levenscyclus om aan de verwachtingen te voldoen en veilig te blijven.

Tegelijkertijd neemt de vraag naar uitlegbaarheid toe. Naarmate AI een grotere rol speelt in bedrijfskritische beslissingen, moeten teams de uitkomsten ervan kunnen begrijpen en verantwoorden tegenover toezichthouders, stakeholders en klanten. Dit leidt tot strengere governance eisen, waarbij veel organisaties AI toezichtrollen formaliseren of speciale ethische commissies in het leven roepen.

Aangaan van de uitdagingen van AI gegevensbeveiliging

De risico’s die AI met zich meebrengt, maken databeveiliging tot een hoge prioriteit. AI systemen werken vaak met gevoelige informatie en vormen daardoor aantrekkelijke doelwitten voor aanvallers die die data willen extraheren of manipuleren.

Om dat goed te managen, verdient het aanbeveling om een managementsysteem te implementeren op basis van ISO 27001 en ISO 42001, aangevuld met risicomanagement conform NIST AI RMF (Risk Management Framework).

Het gebruik van AI systemen is eenvoudig op te nemen in je architectuur als je de basis op orde hebt. Maatregelen als classificatie en toegangsbeheer zorgen dat je grip hebt op je brondata.

| Onze boodschap is: als je de dingen goed doet, ben je voldoende uitgerust om dit AI vraagstuk het hoofd te bieden. |

Effectief AI risicomanagement is afhankelijk van een combinatie van sterke governance, adaptieve technologie en security-first denken op elk niveau. Het cybersecurity team moet daarom vanaf het begin nauw betrokken zijn bij de ontwikkeling van deze tools om ervoor te zorgen dat bedrijven AI technologie kunnen implementeren zonder hun algehele blootstelling aan bedreigingen te beïnvloeden.

Voor meer informatie:

Business Data Challengers: https://www.businessdatachallengers.nl/services/

AI ACT: https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A32024R1689&qid=1758528057657

ISO 42001: https://www.iso.org/standard/42001

NIST AI RMF: https://www.nist.gov/itl/ai-risk-management-framework

IDC: https://blogs.idc.com/2023/05/05/generative-ai-mitigating-data-security-and-privacy-risks/

OWASP Top 10 for LLM applications: https://genai.owasp.org/llm-top-10/

OWASP AI Exchange: https://owaspai.org/